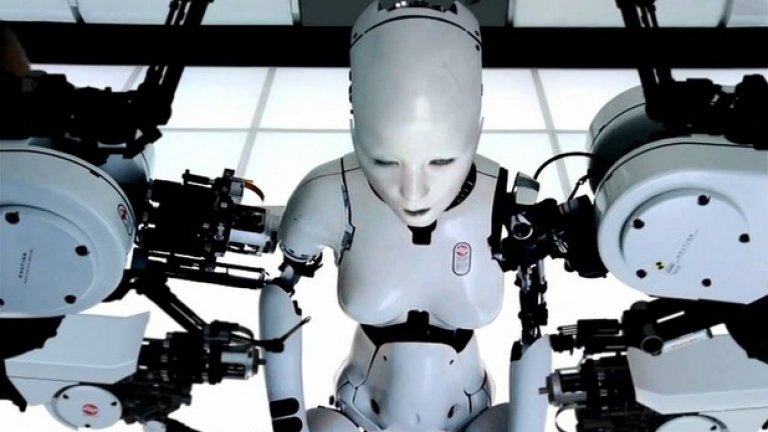

Няма защо да се лъжем: изкуственият интелект е плашещ.

Трудно е да не се боим от него, след като в продължение на десетилетия авторите на книги и филми за научно-фантастични антиутопии са ни предупреждавали, че рано или късно машините ще се обърнат срещу човечеството.

Още през 40-те години Айзък Азимов предлага "трите закона на роботиката":

1) Роботът не може да причини вреда на човек или с бездействието си да допусне на човека да бъде причинена вреда.

2) Роботът е длъжен да се подчинява на човека, ако това не противоречи на Първия закон.

3) Роботът е длъжен да се грижи за собствената си безопасност, ако това не противоречи на Първия и Втория закон.

Технологията на изкуствения интелект (artificial intelligence, AI) се подобрява с изключително бързо темпо. Вярно е, че ако изобщо има някаква опасност от роботите, тя е толкова отдалечена в бъдещето, че нашето поколение едва ли ще я доживее.

И все пак в момента съществуват съвсем непосредствени притеснения от този технологичен бум.

Например, как ще се отрази "поумняването" на автоматизираните роботи върху работните места, които дават препитание на хората? Възможно ли е да загубим завинаги правото си на лично пространство с въвеждането на онлайн-услугите за разпознаване на лица? Как да преотстъпиш моралната си преценка за поведението на пътя на самоуправляващ се автомобил?

Добрата новина е, че някои от най-големите технологични компании в света, които стоят в основата на новата AI-вълна, осъзнават притесненията на хората.

Затова Amazon, Facebook, DeepMind (подразделение на Google), IBM и Microsoft създадоха нова организация, наречена "Партньорство за изкуствен интелект в полза на хората и обществото".

"Всяка нова технология води до промяна, а промяната понякога предизвиква страх у хората, които не я разбират", коментира директорът по AI във Facebook Ян ЛеКун по време на пресконференция, посветена на новия проект.

"Една от целите на тази група е да обясни и да разпространи информацията за способностите на изкуствения интелект - особено по отношение на опасностите и базовите морални въпроси", коментира той.

Не се изненадвайте, ако това ви звучи познато. Директорът на Tesla и SpaceX Илон Мъск говори по този проблем от години.

През декември той създаде организация на име OpenAI, която същосе занимава с разрешаването на конфликтните въпроси около изкуствения интелект. Сама по себе си, обаче, OpenAI е организация за изследователска дейност.

"Партньорството за AI" е нещо съвсем различно. То представлява консорциум, отворен за участие към всички заинтересовани лица, който се опитва да улесни обществения диалог по темите за характера, целите и последствията от изкуствения интелект.

Според Ян ЛеКун, организацията ще работи по три основни направления. Първо - тя ще подпомага комуникацията между специалистите, които разработват AI. Освен това, ще събира допълнителни мнения от изследователите и гражданските организации, така че хората да получат по-мащабна перспектива за влиянието на изкуствения интелект върху обществото като цяло.

"Партньорството" ще информира хората за напредъка на AI - включително като обяснява ползите от него пред законодателната власт, без да лобира в полза на когото и да било.

Създаването на отворен диалог извън ограничена група разработчици на изкуствен интелект е най-важно за проекта, казва ЛеКун.

Вече имаме опит от чат-бота на Microsoft, който сипеше расистки фрази, научени от Twitter. Имаше и конкурс по красота, чието AI-жури реши, че чернокожите хора не са толкова привлекателни, колкото белите.

Ако в развитието на тази технология се включат по-разнообразни мнения, би трябвало вече да не се допускат подобни изкривявания.

Проблемът е, че дори ако тази организация успее да се обедини около система от етични принципи - не е ясно как може да гарантира, че те ще бъдат прилагани на практика.

Една от основните тези на "Партньорството за AI" е, че трябва да се противопоставя на разработването и употребата на изкуствен интелект, които биха могли да доведат до "нарушение на международните споразумения или на човешките права. Въпреки това, целта му не е да въвежда забрани, казва Мустафа Сюлейман, който отговаря за приложните разработки на AI в DeepMind.

С други думи - ако един от членовете на организацията реши да направи нещо очевидно неетично, останалите нямат механизъм, по който да го спрат.

По-скоро ще се занимават със събирането на мнения от обществото, популяризиране на технологията и създаване на добри практики.

Доколко това е достатъчно за разрешаването на проблемите на изкуствения интелект, е спорно, смята Деймиън Уилиамс, преподавател по философия от Университета в Кенесоу, който специализира по въпросите на етиката на нечовешкото съзнание.

Едно от най-големите предизвикателства, според него, е технологичните гиганти да преразглеждат редорвно собствения си модел на мислене, вместо да се мъчат да пишат правила на етиката за "вечни времена".

Все пак той отчита като положителен факт, че компании като Facebook и Google изобщо си задават въпроси за етиката и предразсъдъците при изкуствения интелект.

В идеалния случай, групата ще помогне за създаването на нови стандарти за AI, събирането на данни и създаването на алгоритми, които няма да допускат вредни последици от технологиите.

Това обаче е гигантска задача. Или както казва Ерик Хоровиц от Microsoft Research - тежката работа започва едва сега.